–°–Њ–≤—Б–µ–Љ –љ–µ–і–∞–≤–љ–Њ –Ф–Є–і–∞–Ї—В–Њ—А —Б–Њ–Њ–±—Й–∞–ї –Њ –њ—А–Њ—А—Л–≤–љ–Њ–є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є –њ–Њ –њ—А–µ–≤—А–∞—Й–µ–љ–Є—О —Д–Њ—В–Њ–≥—А–∞—Д–Є–Є –≤ –≥–Њ–≤–Њ—А—П—Й–µ–µ –≤–Є–і–µ–Њ. –Я–Њ–Љ–Є–Љ–Њ –Њ–њ–Є—Б–∞–љ–Є—П —П –Ї–Њ—Б–љ—Г–ї—Б—П —В–∞–Ї–ґ–µ —Н—В–Є—З–µ—Б–Ї–Њ–є –њ—А–Њ–±–ї–µ–Љ—Л –Њ —В–Њ–Љ, —З—В–Њ —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є¬†¬†D-ID –≤–≤–µ–ї–Є –ґ—С—Б—В–Ї–Є–µ –Є –≤–њ–Њ–ї–љ–µ –Њ–њ—А–∞–≤–і–∞–љ–љ—Л–µ —Д–Є–ї—М—В—А—Л –љ–∞ –љ–µ–љ–Њ—А–Љ–∞—В–Є–≤–љ—Г—О –ї–µ–Ї—Б–Є–Ї—Г, —А–∞—Б–Є—Б—В—Б–Ї–Є–µ –≤—Л—Б–Ї–∞–Ј—Л–≤–∞–љ–Є—П –Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є –Є–Ј–≤–µ—Б—В–љ—Л—Е –ї–Є—З–љ–Њ—Б—В–µ–є. –Ь–µ–ґ–і—Г —В–µ–Љ, —П –њ—А–Њ–і–Њ–ї–ґ–Є–ї –њ–Њ–Є—Б–Ї–Є –∞–љ–∞–ї–Њ–≥–Є—З–љ—Л—Е —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є –Є –Њ–±–љ–∞—А—Г–ґ–Є–ї –і—А—Г–≥—Г—О –љ–µ–є—А–Њ—Б–µ—В—М, –Ї–Њ—В–Њ—А–∞—П –њ–Њ–Ј–≤–Њ–ї—П–µ—В —Б–Є–љ—Е—А–Њ–љ–Є–Ј–Є—А–Њ–≤–∞—В—М –≤–Є–і–µ–Њ —Б –ї—О–±—Л–Љ –Ј–≤—Г–Ї–Њ–Љ.¬†

–Ъ–∞–Ї –±—Л –Љ—Л –љ–µ —Б—В—А–µ–Љ–Є–ї–Є—Б—М –Ї –Њ–≥—А–∞–љ–Є—З–µ–љ–Є—П–Љ –≤ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є —В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л—Е –і–Є–њ—Д–µ–є–Ї–Њ–≤, –Њ–љ–Є –≤—Б—С —З–∞—Й–µ –њ–Њ—П–≤–ї—П—О—В—Б—П. –Ш –љ–∞–Љ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –Ј–љ–∞—В—М –њ—А–Є—А–Њ–і—Г –Є—Е –њ—А–Њ–Є—Б—Е–Њ–ґ–і–µ–љ–Є—П –і–ї—П —В–Њ–≥–Њ, —З—В–Њ–±—Л –љ–µ –≤—Б–µ–≥–і–∞ –≤–µ—А–Є—В—М —Г–≤–Є–і–µ–љ–љ–Њ–Љ—Г.

–Ф–Є–њ—Д–µ–є–Ї — —Н—В–Њ –≤–Є–і–µ–Њ—А–Њ–ї–Є–Ї, –≤ –Ї–Њ—В–Њ—А–Њ–Љ –ї–Є—Ж–Њ –Њ–і–љ–Њ–≥–Њ —З–µ–ї–Њ–≤–µ–Ї–∞ –њ–Њ–і–Љ–µ–љ—П–µ—В—Б—П –і—А—Г–≥–Є–Љ –њ—А–Є –њ–Њ–Љ–Њ—Й–Є –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –Њ–±—Г—З–µ–љ–Є—П. –Т —Н—В–Њ–Љ —Б–ї–Њ–≤–µ —Б–Њ–µ–і–Є–љ–µ–љ—Л –і–≤–∞ –њ–Њ–љ—П—В–Є—П: –≥–ї—Г–±–Њ–Ї–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ –љ–µ–є—А–Њ—Б–µ—В–µ–є (deep learning) –Є –њ–Њ–і–і–µ–ї–Ї–∞ (fake).

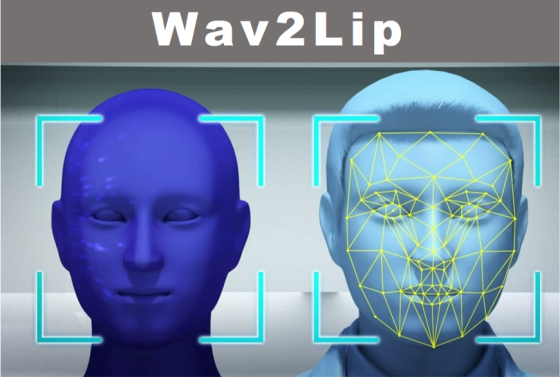

Wav2Lip —¬†—Н—В–Њ¬†–љ–µ–є—А–Њ—Б–µ—В—М, –Ї–Њ—В–Њ—А–∞—П –∞–і–∞–њ—В–Є—А—Г–µ—В –≤–Є–і–µ–Њ —Б –≥–Њ–≤–Њ—А—П—Й–Є–Љ –ї–Є—Ж–Њ –њ–Њ–і –∞—Г–і–Є–Њ–Ј–∞–њ–Є—Б—М —А–µ—З–Є. –Т –Њ—В–ї–Є—З–Є–µ –Њ—В —А—П–і–∞ –∞–љ–∞–ї–Њ–≥–Є—З–љ—Л—Е —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є –Њ–љ–∞¬†–і–Њ–≤–Њ–ї—М–љ–Њ —В–Њ—З–љ–Њ —Б–њ–Њ—Б–Њ–±–љ–∞ –≥–µ–љ–µ—А–Є—А–Њ–≤–∞—В—М –і–≤–Є–ґ–µ–љ–Є—П –≥—Г–± –Ї–∞–Ї –і–ї—П —Б—В–∞—В–Є—З–љ—Л—Е –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є –Є–ї–Є –≤–Є–і–µ–Њ –Њ—В–і–µ–ї—М–љ—Л—Е –ї—О–і–µ–є.

–С–µ–Ј—Г—Б–ї–Њ–≤–љ–Њ, –Ї–∞–ґ–і–∞—П –Є–Ј –Ї–Њ–Љ–њ–∞–љ–Є–є —Б—В—А–µ–Љ–Є—В—Б—П –Ї–∞–Ї –Љ–Њ–ґ–љ–Њ –ї—Г—З—И–µ –њ—А–µ–і—Б—В–∞–≤–Є—В—М —Б–≤–Њ–µ–є –њ—А–Њ–µ–Ї—В. –Ф–∞–≤–∞–є—В–µ –њ–Њ–њ—А–Њ–±—Г–µ–Љ –Є–љ—Б—В—А—Г–Љ–µ–љ—В –≤ —А–∞–Ј–љ—Л—Е —Г—Б–ї–Њ–≤–Є—П—Е.

–†–µ–Ј—Г–ї—М—В–∞—В—Л –∞–њ—А–Њ–±–∞—Ж–Є–Є

–Ф–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ, –Љ—Л –Љ–Њ–ґ–µ–Љ –і–Њ–±–Є—В—М—Б—П –≥–Њ—А–∞–Ј–і–Њ –±–Њ–ї—М—И–µ–≥–Њ —Н—Д—Д–µ–Ї—В–∞.¬†–Ъ –њ—А–Є–Љ–µ—А—Г, –Њ–ґ–Є–≤–Є—В—М –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–µ. –Я—А–∞–≤–і–∞, –≤ –Њ—В–ї–Є—З–Є–µ –Њ—В —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є D-ID¬†–±—Г–і—Г—В —И–µ–≤–µ–ї–Є—В—М—Б—П —В–Њ–ї—М–Ї–Њ –≥—Г–±—Л. –Ю–ґ–Є–≤–ї–µ–љ–Є–µ –Р–љ–і—А–µ—П –Т–Њ–Ј–љ–µ—Б–µ–љ—Б–Ї–Њ–≥–Њ.

–Ъ–Њ–љ–µ—З–љ–Њ, –≥–Њ—А–∞–Ј–і–Њ —Н—Д—Д–µ–Ї—В–љ–µ–µ –Ї–Њ–≥–і–∞ –Љ—Л –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ –≤–Є–і–µ–Њ, –Ј–∞–Љ–µ–љ—П—П —А–µ—З—М –њ–µ—А—Б–Њ–љ–∞–ґ–∞ —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –і—А—Г–≥–Є–Љ —Б–Њ–і–µ—А–ґ–∞–љ–Є–µ–Љ. –Т–Њ—В –Ї–∞–Ї, –Ї –њ—А–Є–Љ–µ—А—Г, –Љ–Њ–ґ–µ—В –≤—Л–≥–ї—П–і–µ—В—М —Б—Д–∞–ї—М—Б–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ–Њ–µ –≤–Є–і–µ–Њ, –Ї–Њ–≥–і–∞ –Љ—Л –≤–ї–Њ–ґ–Є–Љ –≤ —Г—Б—В–∞ –љ–∞—И–µ–≥–Њ –≥–Њ–≤–Њ—А–ї–Є–≤–Њ–≥–Њ –≥–µ–љ—Б–µ–Ї–∞ —Б—В–Є—Е–Є –≤–µ–ї–Є–Ї–Њ–≥–Њ —Б–Њ–≤–µ—В—Б–Ї–Њ–≥–Њ –њ–Њ—Н—В–∞ –†–Њ–±–µ—А—В–∞ –Ш–≤–∞–љ–Њ–≤–Є—З–∞ –†–Њ–ґ–і–µ—Б—В–≤–µ–љ—Б–Ї–Њ–≥–Њ.

–•–Њ—В—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ –≤–љ–µ–і—А–µ–љ–Є–µ –ї—О–±–Њ–≥–Њ —П–Ј—Л–Ї–∞, –≤—Б—С –ґ–µ –љ–∞ –∞–љ–≥–ї–Є–є—Б–Ї–Њ–Љ –і–Є–њ—Д–µ–є–Ї–Є –≤—Л–≥–ї—П–і—П—В –±–Њ–ї–µ–µ –і–Њ—Б—В–Њ–≤–µ—А–љ–Њ. –Ъ –њ—А–Є–Љ–µ—А—Г, –і–∞–≤–∞–є—В–µ –њ–Њ–њ—А–Њ–±—Г–µ–Љ –≤–Њ—Б–њ—А–Њ–Є–Ј–≤–µ—Б—В–Є –љ–∞—З–∞–ї–Њ —А–µ—З–Є –Ь.–°. –У–Њ—А–±–∞—З—С–≤–∞ –љ–∞ XXVII —Б—К–µ–Ј–і–µ –Ъ–Я–°–° –љ–∞ –∞–љ–≥–ї–Є–є—Б–Ї–Њ–Љ —П–Ј—Л–Ї–µ.

–Ъ–∞–Ї –≤–Є–і–Є–Љ, –Ь–Є—Е–∞–Є–ї –°–µ—А–≥–µ–µ–≤–Є—З –љ–µ–њ–ї–Њ—Е–Њ –Є–Ј—К—П—Б–љ—П–µ—В—Б—П –љ–∞ –∞–љ–≥–ї–Є–є—Б–Ї–Њ–Љ.

–Ь—Л –Љ–Њ–ґ–µ–Љ –њ–Њ–Љ–Њ—З—М –њ–Њ–њ—А–∞–≤–Є—В—М «–ї–µ–≥–µ–љ–і–∞—А–љ—Г—О —А–µ—З—М» –Т–Є—В–∞–ї–Є—П –Ь—Г—В–Ї–Њ –љ–∞ –Є—Б—В–Њ—А–Є—З–µ—Б–Ї–Њ–Љ –Ј–∞—Б–µ–і–∞–љ–Є–Є –§–Ш–§–Р –Є –љ–µ —Б–Љ—Г—Й–∞—В—М—Б—П –µ–≥–Њ –њ—А–Њ–Є–Ј–љ–Њ—И–µ–љ–Є–µ–Љ.

–С–µ–Ј—Г—Б–ї–Њ–≤–љ–Њ, –≤–Є–і–µ–Њ –Є –Ј–≤—Г–Ї —Б–ї–µ–і—Г–µ—В –њ–Њ–і–±–Є—А–∞—В—М –Ї—А–∞–є–љ–µ —В—Й–∞—В–µ–ї—М–љ–Њ. –Я—А–µ–ґ–і–µ –≤—Б–µ–≥–Њ, –њ–Њ —В–µ–Љ–њ—Г –њ—А–Њ–Є–Ј–љ–Њ—И–µ–љ–Є—П. –С–Њ–ї—М—И–Њ–µ –Ј–љ–∞—З–µ–љ–Є–µ –Є–Љ–µ–µ—В –Ї–∞—З–µ—Б—В–≤–Њ –≤–Є–і–µ–Њ, –Њ—В—Б—Г—В—Б—В–≤–Є–µ —И—Г–Љ–∞ –≤ –≤–Є–і–µ –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ—Л—Е –њ–µ—А—Б–Њ–љ–∞–ґ–µ–є. –Х—Б–ї–Є –Љ—Л —Е–Њ—В–Є–Љ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –Љ—Г–Ј—Л–Ї–∞–ї—М–љ—Л–µ —Д–∞–є–ї—Л, —В–Њ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –њ–Њ–і–±–Є—А–∞—В—М, –њ—А–µ–ґ–і–µ –≤—Б–µ–≥–Њ —Б –Њ—В—Б—Г—В—Б—В–≤–Є–µ–Љ –Є–љ—Б—В—А—Г–Љ–µ–љ—В–Њ–≤–Ї–Є.

–Э–µ–±–Њ–ї—М—И–Њ–є –њ—А–Є–Љ–µ—А: –Ы—Г—З–∞–љ–Њ –Я–∞–≤–∞—А–Њ—В—В–Є –њ–Њ—С—В –≥–Њ–ї–Њ—Б–Њ–Љ –°–µ—А–≥–µ—П –Ы–µ–Љ–µ—И–µ–≤–∞.

–Ф–Њ–ї–≥–Њ –і—Г–Љ–∞–ї, —Б—В–Њ–Є—В –ї–Є –њ–Є—Б–∞—В—М –Є –і–µ–Љ–Њ–љ—Б—В—А–Є—А–Њ–≤–∞—В—М –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ–Њ–і–Њ–±–љ—Л—Е —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є, –Ї–Њ—В–Њ—А—Л–µ –Љ–Њ–≥—Г—В –≤–Њ—Б–њ—А–Є–љ–Є–Љ–∞—В—М—Б—П –Ї–∞–Ї –њ–Њ–њ—Г–ї—П—А–Є–Ј–∞—Ж–Є—П —Б–Њ–Ј–і–∞–љ–Є—П –і–Є–њ—Д–µ–є–Ї–Њ–≤. –Ґ–µ–Љ –±–Њ–ї–µ–µ –Є—Е –њ–Њ—П–≤–ї–µ–љ–Є–µ —Н—В–Њ —Г–ґ–µ –љ–µ —И—Г—В–Њ—З–љ—Л–µ —Д–∞–є–ї—Л, –∞ –Ј–∞—З–∞—Б—В—Г—О —П–≤–љ–∞—П –і–µ–Ј–Є–љ—Д–Њ—А–Љ–∞—Ж–Є—П, –Ї–Њ—В–Њ—А–∞—П –Љ–Њ–ґ–µ—В —Б—Л–≥—А–∞—В—М —П–≤–љ–Њ –љ–µ–≥–∞—В–Є–≤–љ—Г—О —А–Њ–ї—М. –Ю–і–љ–∞–Ї–Њ –≤—Б–µ–≥–і–∞ –љ–∞–є–і—Г—В—Б—П –ґ–µ–ї–∞—О—Й–Є–µ —Б–і–µ–ї–∞—В—М —Н—В–Њ.

–Т –Њ–±—А–∞–Ј–Њ–≤–∞—В–µ–ї—М–љ—Л—Е —Ж–µ–ї—П—Е¬† —Б –њ–Њ–Љ–Њ—Й—М—О –і–∞–љ–љ–Њ–є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є –Љ—Л, –±–µ–Ј—Г—Б–ї–Њ–≤–љ–Њ, –Љ–Њ–ґ–µ–Љ —Б–Њ–Ј–і–∞–≤–∞—В—М –Њ–Ј–≤—Г—З–µ–љ–љ—Л–µ –≤–Є–і–µ–Њ –і–ї—П :

- –Њ–Ј–≤—Г—З–Є–≤–∞–љ–Є—П –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є

- –Є—Б–њ—А–∞–≤–ї–µ–љ–Є—П¬†–Є–Љ–µ–≤—И–Є—Е—Б—П –≤ –њ–µ—А–≤–Њ–љ–∞—З–∞–ї—М–љ–Њ–Љ –≤–Є–і–µ–Њ –і–µ—Д–µ–Ї—В–Њ–≤ —А–µ—З–Є, –љ–µ–љ—Г–ґ–љ—Л—Е —Б–ї–Њ–≤ –Є –Љ–µ–ґ–і–Њ–Љ–µ—В–Є–є, –±–ї–∞–≥–Њ–і–∞—А—П –≤–љ–µ–і—А—С–љ–љ–Њ–Љ—Г –Ј–≤—Г–Ї–Њ–≤–Њ–Љ—Г —Д–∞–є–ї—Г

- —Г–≤–µ–ї–Є—З–µ–љ–Є—П —З–Є—Б–ї–∞ –≤–Є—А—В—Г–∞–ї—М–љ—Л—Е –і–Є–Ї—В–Њ—А–Њ–≤ –Ј–∞ —Б—З—С—В –≤—Л–Љ—Л—И–ї–µ–љ–љ—Л—Е –Є–ї–Є —А–µ–∞–ї—М–љ—Л—Е —Г—З–∞—Б—В–љ–Є–Ї–Њ–≤ —Б–Њ–±—Л—В–Є–є –Є —В.–њ.

- –і–µ–Љ–Њ–љ—Б—В—А–∞—Ж–Є–Є —А–∞–Ј–ї–Є—З–Є–є –њ–Њ–і–ї–Є–љ–љ–Є–Ї–Њ–≤ –Є –і–Є–њ—Д–µ–є–Ї–Њ–≤

–Т–Њ–Ј–Љ–Њ–ґ–µ–љ –Є —А—П–і –і—А—Г–≥–Є—Е —Б–ї—Г—З–∞–µ–≤.

–Ш—Б–њ–Њ–ї—М–Ј—Г—П¬†–Ї–Њ–і¬†–њ—А–Њ–≥—А–∞–Љ–Љ—Л¬†—Б –Њ—В–Ї—А—Л—В—Л–Љ –Є—Б—Е–Њ–і–љ—Л–Љ –Ї–Њ–і–Њ–Љ, –≤—Л –Љ–Њ–ґ–µ—В–µ –њ–Њ–њ—Л—В–∞—В—М—Б—П —Б–Є–љ—Е—А–Њ–љ–Є–Ј–Є—А–Њ–≤–∞—В—М –≤–Є–і–µ–Њ —Б –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Є–Љ —А–∞–Ј—А–µ—И–µ–љ–Є–µ–Љ –Є–ї–Є –±–Њ–ї–µ–µ –і–ї–Є–љ–љ—Л–Љ¬†–њ–Њ –≤—А–µ–Љ–µ–љ–Є. –Т—Л —Б–Љ–Њ–ґ–µ—В–µ –љ–∞—Б—В—А–Њ–Є—В—М –њ–∞—А–∞–Љ–µ—В—А—Л –≤—Л–≤–Њ–і–∞ –Є, —Б–ї–µ–і–Њ–≤–∞—В–µ–ї—М–љ–Њ, –њ–Њ–ї—Г—З–Є—В—М –≥–Њ—А–∞–Ј–і–Њ –ї—Г—З—И–Є–є —А–µ–Ј—Г–ї—М—В–∞—В –і–ї—П —В–µ—Е –ґ–µ –≤—Е–Њ–і–љ—Л—Е –і–∞–љ–љ—Л—Е. –Ю–і–љ–∞–Ї–Њ –і–ї—П —Н—В–Њ–≥–Њ –≤–∞–Љ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –Љ–љ–Њ–≥–Њ –±—Г–і–µ—В –њ–Њ—В—А—Г–і–Є—В—М—Б—П.